GLM-4.5 智谱推出的面向推理、代码与智能体的开源 SOTA 模型

时间:2025-07-31

-

-

瓜子影视最新官方app

- 类型:

- 大小:

- 语言:简体中文

- 评分:

- 查看详情

GLM-4.5 智谱推出的面向推理、代码与智能体的开源 SOTA 模型

GLM-4.5是什么

glm-是智谱公司最新研发的顶级旗舰模型,专为智能体应用设计,是首款结合了推理、编程能力和智能体功能的开源 SOTA 模型。采用混合专家(moe)架构,并有两个版本:glm-参数,激活)和 glm-air(亿参数,亿激活)。它在多个评测基准中表现出色,综合性能达到开源模型的顶尖水平,在代码智能体方面尤为出色。glm-持混合推理模式,提供思考与非思考两种模式,能满足复杂任务和即时响应的需求。

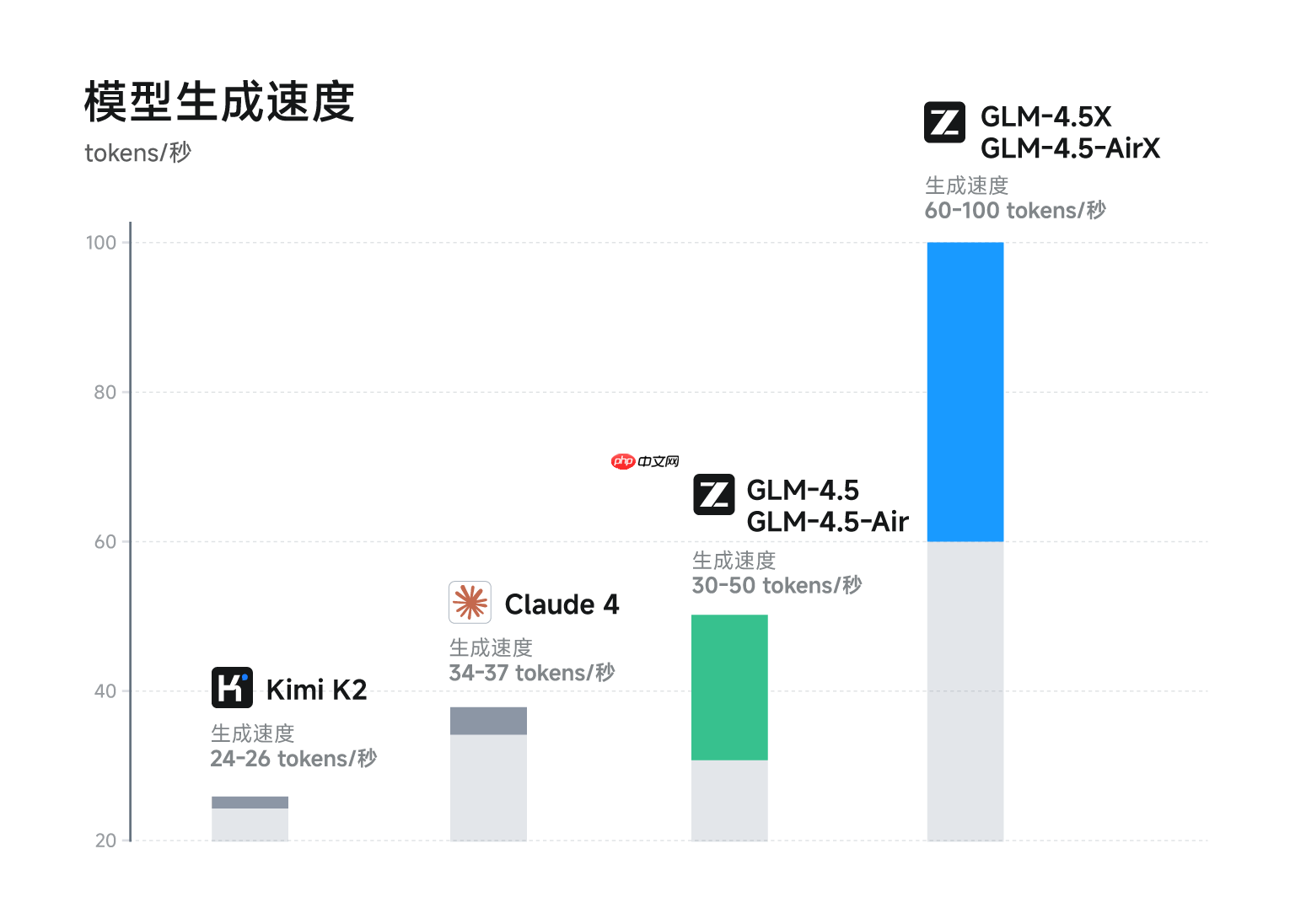

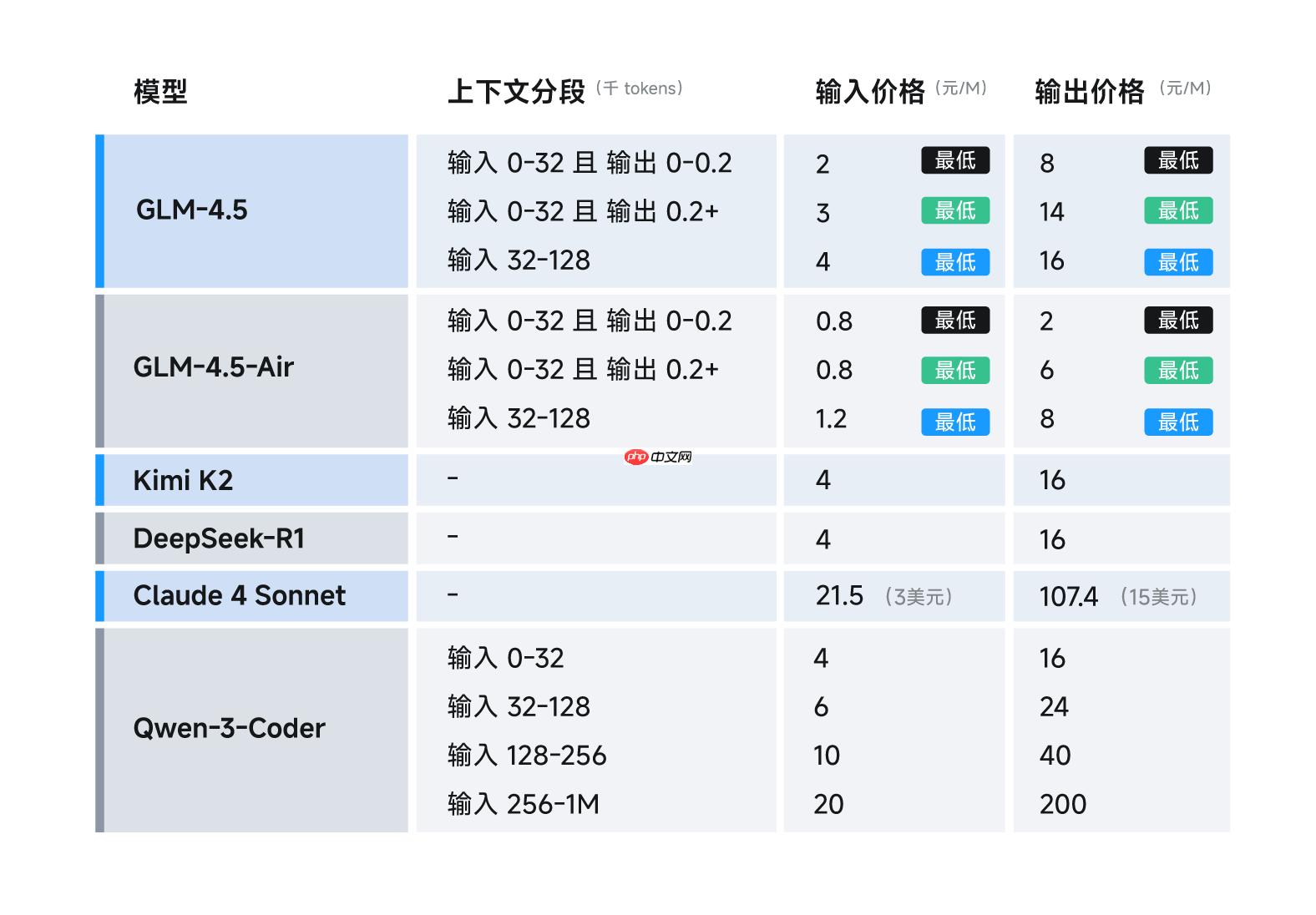

参数效率翻倍,API价格仅为Claude的1/10,速度最快可达100tokens/秒。率先在一个模型中实现多能力原生融合并取得重要技术突破单个模型同时具备强大的推理、代码、智能体等能力,已上线智谱清言和Z.ai开放免费体验。

GLM-4.5的主要特点

全新的能力融合:一次在单一架构中实现了推理、代码生成与智能体功能的全面集成,满足了复杂智能体应用的需求。推理能力: - 在多个推理评测基准上表现卓越,支持复杂的推理任务。 - 推理性能达到了开源模型的顶尖水平。代码生成: - 在代码生成和编程任务中展现出色的表现,支持多种编程语言。 - 能生成高质量的代码片段,胜任全栈开发任务。智能体应用: - 支持工具调用、网页浏览等功能。 - 能接入代码智能体框架,如 Claude Code 和 Roo Code,适用于智能体任务。混合推理模式: - 提供“思考模式”用于处理复杂推理和使用工具时的即时响应。 - 同时提供“非思考模式”以提高效率,平衡了速度与性能。

GLM-4.5的技术亮点

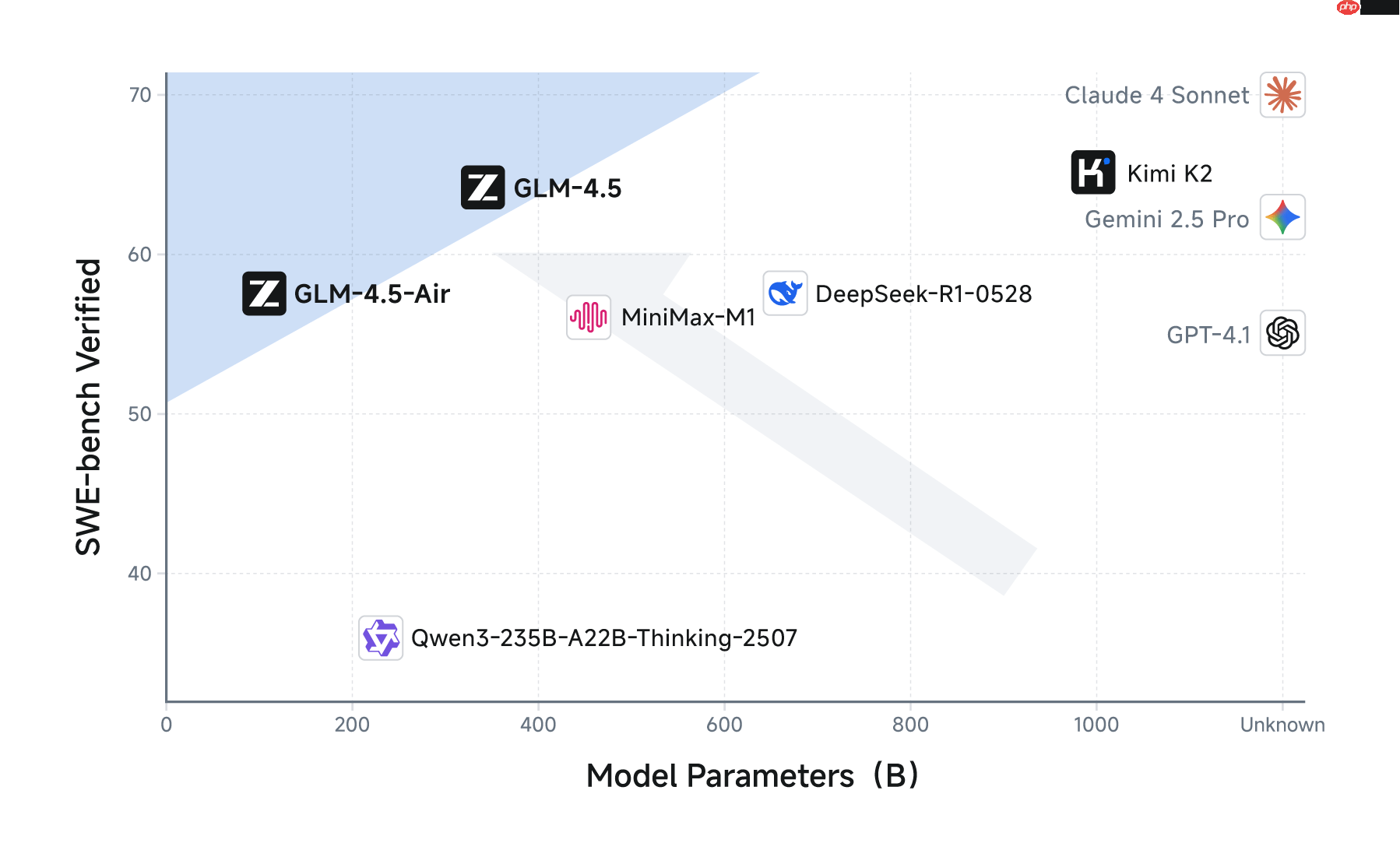

混合专家架构:通过混合专家(Mixture of Experts, MoE)技术,GLM-实现了高效的模型扩展方法。MoE 架构将模型参数划分为多个专家模块,在每个前向传播过程中动态选择部分专家进行激活,从而实现参数的稀疏激活,降低计算成本和内存占用。具体而言,GLM-总共使用 个参数,其中激活参数只有 。相比于传统模型,这种方法大大减少了数据处理的需求,并且在任务处理能力上也得到了显著提升。多模态能力是 GLM-的核心优势之一。它不仅能够处理文本、图像等多种类型的数据,还支持多模态输入和输出,能有效解决智能体任务中的多模态交互场景。例如,在网页浏览、工具调用等复杂场景中,GLM-能够提供更加准确和高效的服务。混合推理模式是 GLM-的另一个关键特点。它提供了两种不同的推理方式:思考模式(Thinking Mode)和非思考模式(Non-Thinking Mode)。前者适用于需要深度理解和详细推理的场景,如复杂的推理问题或工具使用情况;后者则适合快速响应的需求,适用于实时交互。训练流程是 GLM-的另一个亮点。首先,它进行通用数据预训练,在 亿个词的基础上构建了一个强大的基础表示。然后针对特定领域的 亿个 token 数据进行有针对性的训练,使模型在相应任务上表现得更好。最后,通过强化学习优化推理、代码生成和智能体能力,进一步提升实际应用中的表现。参数效率是 GLM-的另一个显著优势。尽管它的参数量仅为 DeepSeek-R的 并且与 Kimi-K比也有大幅度的降低(达到其的,但在多项标准基准测试中仍然表现出色。例如,在推理性能方面,GLM-在 Artifical Analysis 基准测试中的表现达到了甚至超过了国际顶级模型。总的来说,混合专家架构的引入使得 GLM-成为了多模态智能体领域的有力竞争者,并且在参数效率和训练流程上都取得了巨大的进步。

GLM-4.5的项目地址

GitHub仓库:http://github.com/zai-org/GLM-4.5 HuggingFace仓库: http://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b ModelScope仓库:http://modelscope.cn/collections/GLM-45-b8693e2a08984f 体验地址: HuggingFace: http://huggingface.co/spaces/zai-org/GLM-4.5-Space ModelScope:http://modelscope.cn/studios/ZhipuAI/GLM-4.5-Demo

GLM-4.5的技术指标

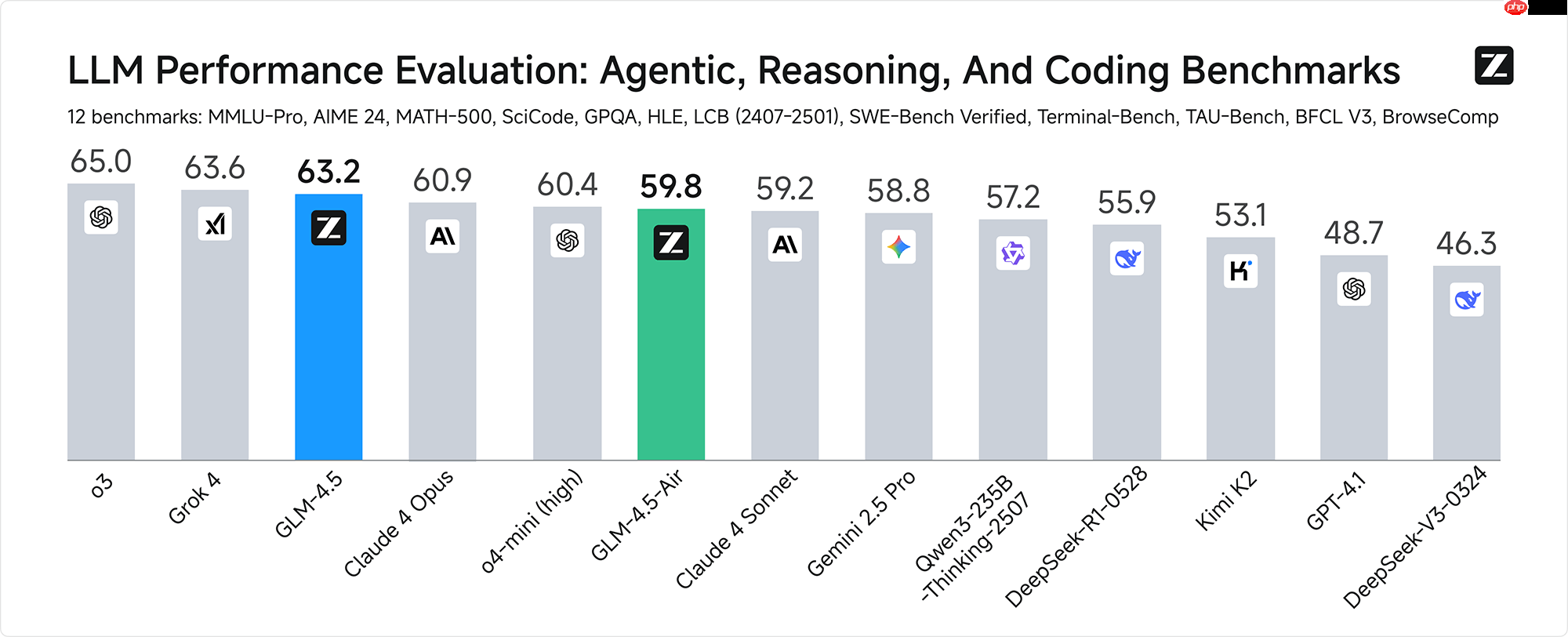

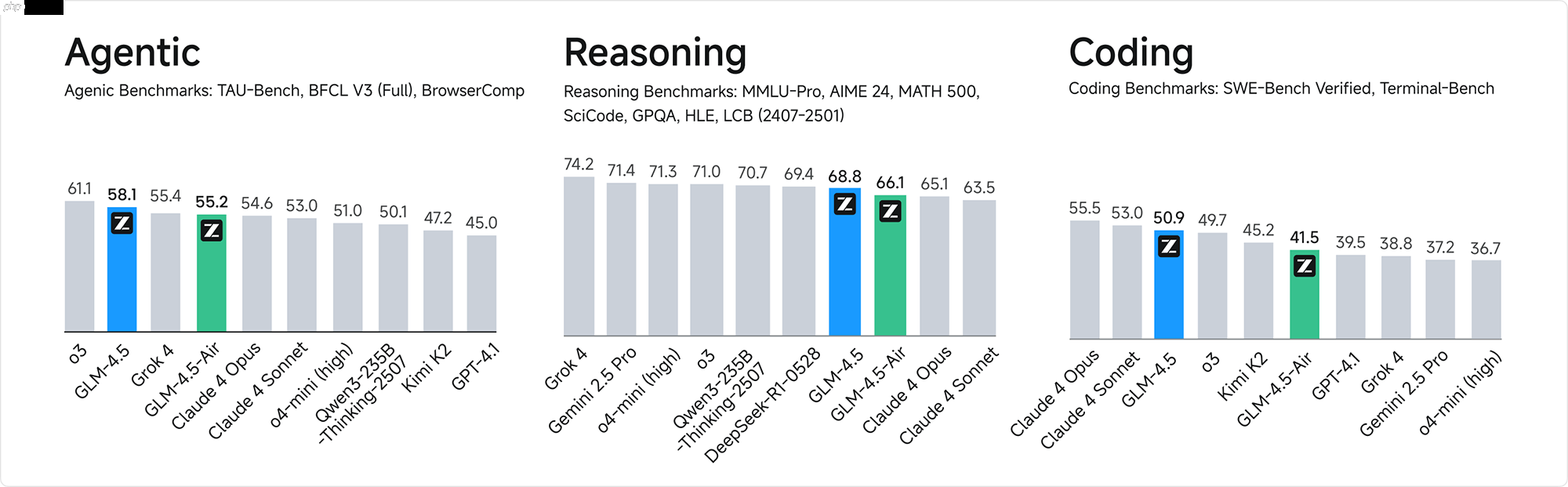

综合性能SOTA:最具有代表性的评测基准在人工智能领域,综合性能达到了顶峰的模型被称为“SOTA”(State-of-the-Art)。以下是最具代表性且经过测试的模型: MMLU Pro - 一个基于机器学习和自然语言处理的研究项目。 AIME * - 针对人工智能任务性能优化的标准基准。 MATH * - 用于评估数学技能模型的整体性能。 SciCode - 研究科学代码编写能力的模型。 GPQA - 高效自然语言生成评测基准。 HLE - 集成式语音识别与语义理解系统。 LiveCodeBench - 测试交互式代码编程环境性能的标准。 SWE-Bench Verified - 用于衡量模型的代码能力及正确性的标准基准。 Terminal-Bench - 对终端设备上运行的程序进行测试,评估性能。 TAU-Bench - 模拟真实用户操作场景的负载压力测试。 BFCL v* - 用于验证和优化机器学习模型的基准工具。 BrowseComp - 通过模拟浏览器实际行为来衡量网页加载速度的标准。综合平均分方面,GLM-多项标准评测中取得了显著成绩。具体来说,它在全球范围内位列第三,而其作为国产模型和开源模型都获得了第一的排名。同时,在衡量模型代码能力的SWE-bench Verified榜单上,GLM-列位于性能/参数比帕累托前沿,进一步表明在相同规模下实现了最佳性能。不仅如此,通过高效的参数管理和成本优化策略,GLM-系列不仅显著减少了训练时间,还大幅度降低了计算资源需求。特别是在衡量模型代码能力的SWE-bench Verified榜单上,它位于性能/参数比帕累托前沿,这表明在相同规模下实现了最佳性能。此外,在确保模型质量和准确性的基础上,GLM-系列也表现出了低成本、高速度的特点。相比主流模型定价,API调用价格低至输入/百万tokens,输出/百万tokens,且生成速度最高可达tokens/秒,这不仅提高了用户体验的即时响应时间,还提供了高并发运行的支持能力,满足了实际部署需求中的低成本效益与交互体验。

如何使用GLM-4.5

智谱清言 (chatglm.cn):欢迎使用我们的平台!体验 GLM-的满血版功能吧。无需注册或付费,即可进行对话生成、代码生成和各种推理任务。Z.ai:同样地,您也可以通过 Z.ai 平台来体验这一强大的模型。在 Z.ai 中,您可以探索 GLM-的多种应用场景。API 调用: BigModel.cn:智谱 AI 提供了全面的 API 接口,涵盖了文本生成、代码生成和推理任务等多种功能。只需通过 BigModel 平台进行简单调用,便能立即体验到模型的强大能力。无论是 GLM-的免费版还是付费版,都能满足您的各种需求。现在就开启您的智能旅程吧!

GLM-4.5的模型定价

使用我们的服务,API调用只需花费:输入成本仅为/百万tokens,而输出价格更是低廉至/百万tokens!生成速度之快可达到每秒token,轻松应对各种需求,并且支持低延迟和高并发部署。立即体验超凡的效率与性能!

GLM-4.5的应用场景

全栈开发任务:GLM-能胜任复杂的全栈开发任务,支持编写复杂的应用、游戏和交互网页。代码生成:GLM-在代码生成方面表现出色,能生成高质量的代码片段,并支持多种编程语言,帮助开发者快速生成代码框架、修复错误并优化结构。 编程辅助:模型可以作为编程辅助工具,提供代码补全、代码生成建议及代码注释功能,显著提高开发效率和代码质量。内容生成:GLM-还能生成各类类型的内容,如文章、新闻报道、创意文案等,适用于内容创作、文案撰写等多种应用场景。 学术研究:GLM-可用于学术研究,帮助研究人员探索自然语言处理、人工智能等领域前沿问题。

以上就是GLM-4.5 智谱推出的面向推理、代码与智能体的开源 SOTA 模型的详细内容,更多请关注其它相关文章!