DeepSeek本地部署详细步骤教学指南

时间:2025-08-06

-

-

真正的出租车驾驶大城市

- 类型:

- 大小:

- 语言:简体中文

- 评分:

- 查看详情

DeepSeek本地部署详细步骤教学指南

深思熟虑的DeepSeek是杭州深度求索人工智能基础技术研究有限公司打造的大语言模型LLM研发和应用平台。在部署前,请务必确认您的计算机满足以下基本条件:强大且稳定的服务器、足够的存储空间以及合适的硬件配置,例如高性能处理器和充足的内存。

* 操作系统:linux(推荐)或windows

* python版本:>=3.7

* 依赖包:pytorch(>=1.7.1)、transformers(>=4.0)

同时,你还需要准备一些其他相关的库,如numpy、pandas、scikit-learn等。

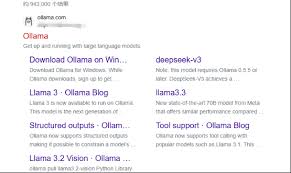

二、安装ollama

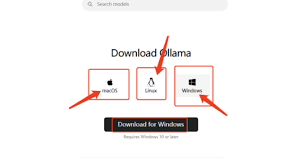

ollama是deepseek的依赖工具,你需要先安装它。以下是ollama的安装步骤:

- 访问[ollama官网](https://ollama.com/),根据你的操作系统下载对应的安装包。

- 下载完成后,以管理员身份运行安装包进行安装。

安装完成后,使用命令 ollama 并按回车键,检查是否显示相关信息,以确认安装成功。

对于linux系统,你可以使用以下命令进行一键安装:

```bash

curl -fssl https://ollama.com/install.sh | sh

```

然后配置权限并启动服务:

```bash

sudo usermod -ag ollama $user

newgrp ollama

systemctl start ollama

systemctl enable ollama

```

对于windows系统,你需要下载安装包并进行双击安装。安装完成后,你可以在命令行使用“ollama list”命令查看已安装的模型。

三、下载并部署deepseek模型

接下来,你需要下载并部署deepseek模型。以下是具体步骤:

访问Ollama的DeepSeek模型库页面,根据你的电脑配置选择合适的模型版本。参数量越大的模型需要更多的GPU资源,适合显卡显存为或的用户;如果你的显卡显存更少,可以选择或参数较小的版本以节省资源。

在命令行中执行相应的命令以下载并运行模型。比如,如果你想下载版本的DeepSeek模型,只需键入特定指令即可。

```bash

ollama pull deepseek-r1:8b

ollama run deepseek-r1:8b

```

完成之后,系统将自动下载并启动模型服务。下载完毕后,可直接进入交互模式与模型交流。

四、测试deepseek模型交互

在命令行中,你可以通过输入问题来测试deepseek模型的交互。例如:

```bash

ollama run deepseek-r1:8b

```

当你提出问题时,请输入相关内容,我们的智能系统将立即提供详细解答。请稍等片刻,由于网络延迟可能造成响应迟缓,确保多进行几遍确认即可快速获取答案。

五、增强交互体验:安装open webui

为了提升用户体验,你可尝试安装open webui。这是一个基于Web的交互界面,让你能更加轻松地与DeepSeek模型交流。以下是安装指南:

- 访问open webui的官方文档页面,获取安装指令。

- 使用docker进行安装。如果你还没有安装docker,可以从docker官网下载并安装。

- 在命令行输入以下命令来运行open webui:

```bash

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

```

在本地浏览器中打开 http://localhost:,登录WebUI界面,并注册为管理员以进行首次操作。

登录后,通过点击“添加本地模型”按钮,输入所需模型的名称及运行指令,确认无误后保存设置。随后,在主页上找到相应模型,并轻松启动与之交流的过程!

六、故障排查与优化建议

在执行并应用deepseek模型时,可能遭遇若干问题。这里提供了一些常见故障解决技巧与改进建议。

- 如果ollama服务无法启动,可以查看日志文件或使用“journalctl -u ollama -f”命令来查看服务状态。

- 如果模型加载失败,可以尝试重新初始化模型或检查网络连接。

为了提升性能,你可以依据硬件配置选择运行方式,例如仅使用CPU或结合CPU和GPU的混合方法。此外,运用定量分析模型也可有效降低内存需求。

通过以上步骤,你就可以成功地在本地部署deepseek模型,并与其进行交互对话了。希望这篇手把手教学对你有所帮助!